首先看看springboot内置的tomcat,该如何配置这两个参数

# 在配置文件中添加如下内容 # tomcat最大线程数,默认为200 server.tomcat.max-threads=200 # tomcat最大连接数,默认为10000(网上的说法) server.tomcat.max-connections=300

如何理解上面两个参数

为了方便理解,我这里使用了springboot编写了一个简单了的服务,包含一个模拟登录的接口,并使用jmeter进行测试,不了解jmeter如何使用的朋友可以翻看我的历史文章。部分代码如下

// java 代码@RestController@RequestMapping("/user")public class UserController {

@Autowired

private UsersRepository usersRepository;

@PostMapping("/login")

public String login(Users user) throws InterruptedException {

// 这里将线程挂起3秒,方便观察结果

Thread.sleep(3000);

Users checkUser = usersRepository.findByName(user.getName());

if(checkUser == null)

return "用户不存在";

if(!checkUser.getPassword().equals(user.getPassword()))

return "密码错误";

System.out.println("用户:" + checkUser.getName() + ",登录成功");

return "登录成功";

}}接下来,设置jmeter中的线程数,分别测试以下场景返回的结果

注意:我在java代码中添加将线程挂起3秒的语句,实际的响应时间应该减去3秒

场景1:并发请求数 <= tomcat最大线程数200

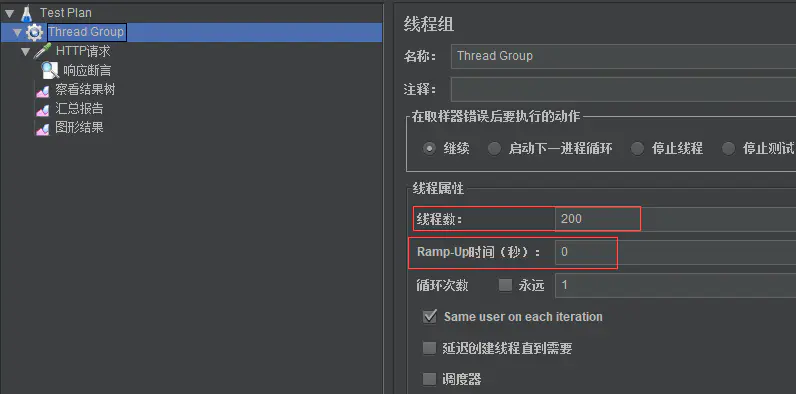

设置jmeter并发请求数量为200

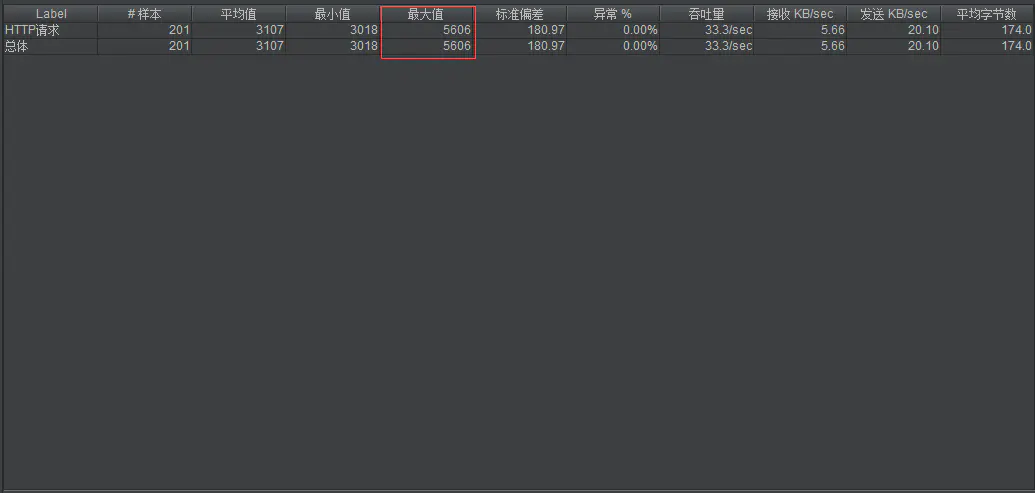

结果统计

结论:可以看到200个请求,平均响应时间为(3156-3000)=156ms,最小响应时间为23ms,最大响应时间为336ms,响应结果正常。

场景2:并发数 >tomcat最大线程数200,以下我将jmeter线程数设置为201,再来看看结果

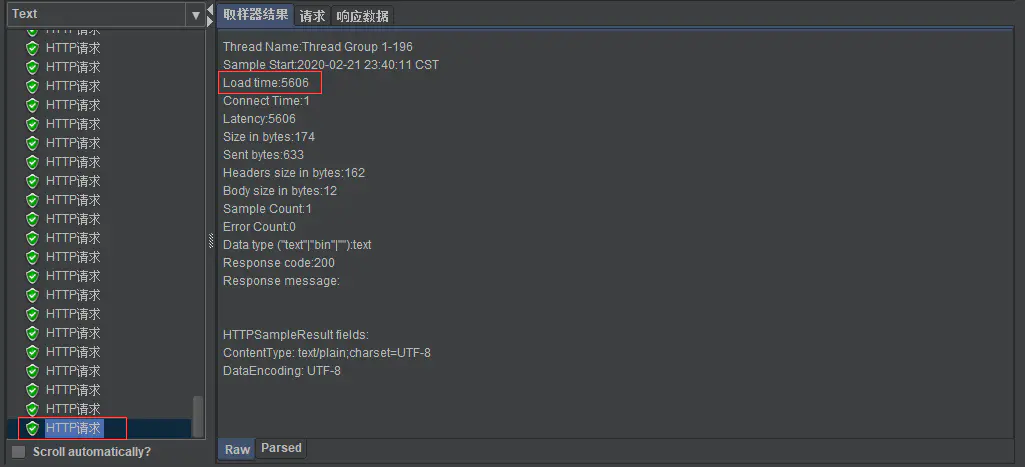

看了下,平均值,最小值好像没什么异常,但是最大值却去到了5606毫秒,接近6S的时间。为什么会有个接近6S的最大值,原因很简单,因为tomcat最大的线程数为200,201的并发请求量,超出了并发处理的数量200,多出来的1个请求,需要等待某个处理中的请求处理完成。

这里我翻看了jmeter中大部分的http请求,验证了我的想法。大部分的http请求,响应时间都是3000多毫秒,只有最后一个响应的请求,响应的时间为5606毫秒,截图如下

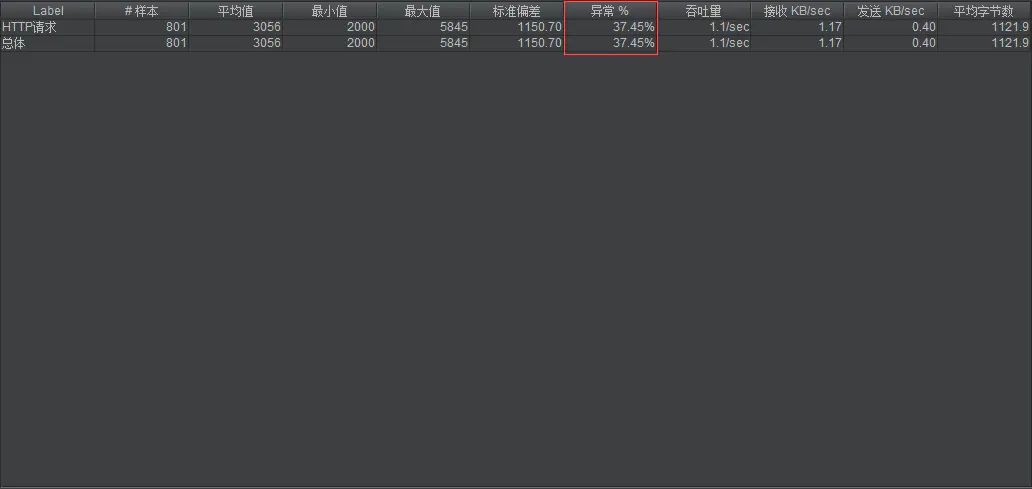

场景3:请求数超过最大连接数300,这里将jmeter并发线程数设置为600

异常数量由原本的百分之0变成37.45%

可以看到有大量的没有正常响应的http请求,原因很简单,因为超过了tomcat设置的最大连接数,服务器拒绝了该次请求的连接

作者:裂开的汤圆

链接:https://www.jianshu.com/p/35878d4ec130

最新评论: